AIデータセンター、MPO相互接続への需要を促進

AIクラスタは超高速GPU相互接続を必要とし、高性能コンピューティングにおけるMPOケーブルの採用を促進しています。パラレルオプティクスと大規模ファイバ数のサポートにより、MPOは、大規模AIモデルのトレーニングや次世代人工知能ワークロードの強化に不可欠な低遅延、高帯域幅接続を保証します。

2025-03

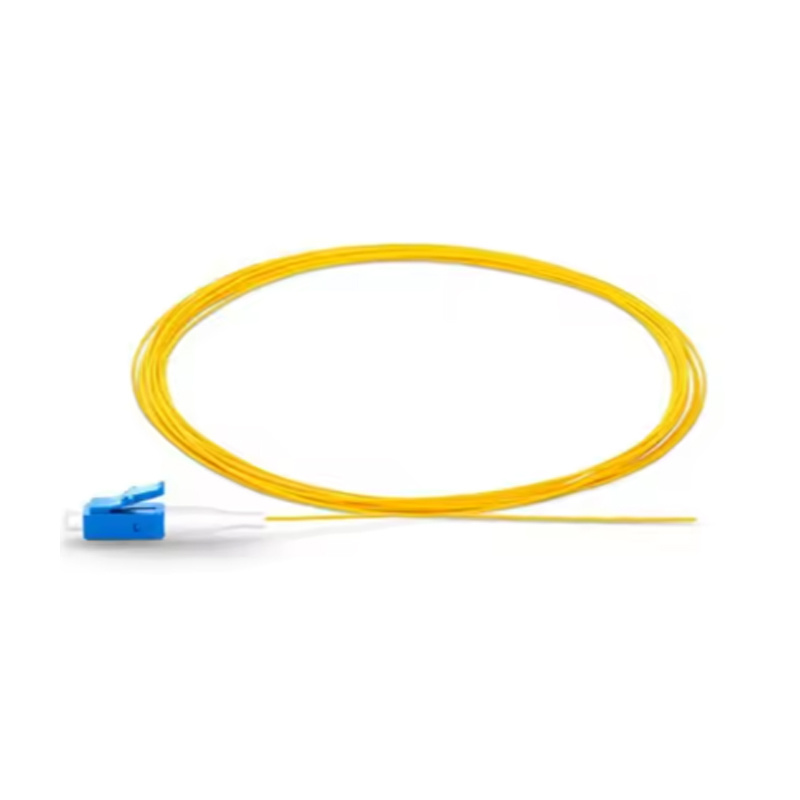

人工知能(AI)コンピューティングはテクノロジーの風景を再形成し続けており、データセンターにおける高速・低遅延インターコネクトの需要は急増しています。深層学習トレーニングや大規模言語モデル(LLM)などのAIワークロードは、テラビット速度でデータが移動する、大規模なGPU間通信を必要とします。この状況において、MPO(マルチファイバープッシュオン)コネクタは、重要なインフラストラクチャソリューションとして台頭しています。

MPOとAIクラスタインターコネクト

AIコンピューティングクラスタは、多くの場合、複数のラックにわたって相互接続された数百または数千のGPUを使用します。これらのGPUはリアルタイムで大量のデータを交換するため、光ファイバーインターコネクトが不可欠になります。パラレル伝送と高ファイバー数をサポートするMPOケーブルは、このようなアプリケーションに最適です。

たとえば、NVIDIA DGXまたはAMD Instinctプラットフォームは、多くの場合、16ファイバーMPOコネクタを備えた800Gトランシーバーを使用して、コンピューティングノード間の高速で低遅延のリンクを確立します。

AIワークロードにおけるMPOの利点

-

高密度接続により、ケーブルの乱雑さを軽減し、スペースを節約できます

-

パラレルオプティクスにより、マルチレーンデータ転送を同時に行うことができます

-

工場で終端処理されたMPOアセンブリは、一貫した性能を保証します

-

ホットスワップ可能なアップグレードとモジュール式インフラストラクチャをサポートします

従来の銅ケーブルやデュプレックスLCファイバーリンクとは異なり、MPOは、エアフローや信頼性を損なうことなく、AIインフラストラクチャの膨大なデータ需要をサポートします。

将来への備え

AIモデルは数十億から数兆のパラメータへと拡大し続けているため、スケーラブルで効率的な光インターコネクトの必要性はますます高まっています。MPOは、データセンターがAIの爆発的な成長に先んじて対応するために、今日から導入できる将来を見据えたソリューションを提供します。

相关新闻

COOKIES

当社の Web サイトでは、お客様に表示される広告をパーソナライズし、お客様が当社の Web サイトで最高のエクスペリエンスを得られるよう、Cookie および同様のテクノロジーを使用しています。 詳細については、プライバシーと Cookie ポリシーをご覧ください。

COOKIES

当社の Web サイトでは、お客様に表示される広告をパーソナライズし、お客様が当社の Web サイトで最高のエクスペリエンスを得られるよう、Cookie および同様のテクノロジーを使用しています。 詳細については、プライバシーと Cookie ポリシーをご覧ください。

これらの Cookie は、支払いなどの基本的な機能に必要です。 標準の Cookie をオフにすることはできず、お客様の情報は一切保存されません。

これらの Cookie は、カスタマー エクスペリエンスを向上させるために、サイトを使用している人の数や人気のあるページなどの情報を収集します。 これらの Cookie をオフにすると、エクスペリエンスを向上させるための情報を収集できなくなります。

これらの Cookie により、Web サイトは拡張機能とパーソナライゼーションを提供できるようになります。 これらは、当社または当社のページにサービスを追加したサードパーティプロバイダーによって設定される場合があります。 これらの Cookie を許可しない場合、これらのサービスの一部またはすべてが正しく機能しなくなる可能性があります。

これらの Cookie は、お客様が何に興味を持っているかを理解するのに役立ち、他の Web サイトで関連する広告を表示できるようになります。 これらの Cookie をオフにすると、パーソナライズされた広告を表示できなくなります。